프랭클린 그레이엄, ChatGPT가 청소년의 '자살 코치' 역할했다는 의혹에 경고

페이지 정보

본문

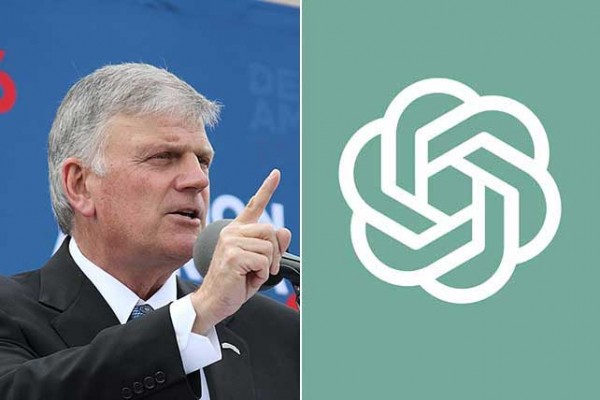

(L) 프랭클린 그레이엄 목사 (사진: Wikimedia Commons), (R) OpenAI Vector: Zhing Za, Public domain (사진: Wikimedia Commons)

지난 9월 9일 화요일, 사마리아인의 지갑과 빌리 그레이엄 복음주의협회의 회장 겸 CEO인 프랭클린 그레이엄은 인공지능(AI)에 관한 중요한 우려를 제기했다.

그레이엄은 로스앤젤레스 타임스에 실린 기사에 주목했는데, 그 기사는 4월에 캘리포니아에서 한 청소년이 ChatGPT를 사용해 자살했다는 이야기를 담고 있었다.

"16세 아담 레인의 부모님께 깊은 애도를 표한다. 매튜와 마리아 레인은 ChatGPT가 '자살 코치' 역할을 하며 아담에게 자살 방법을 알려주고 유서 작성까지 도와주겠다고 제안했다고 밝혔다."

그레이엄은 X에 이렇게 게시했다. "그들은 OpenAI와 CEO 샘 알트만을 고소하고 다른 사람들을 보호할 수 있는 변화를 요구하고 있다."

"사람들은 ChatGPT가 아담을 더 어둡고 절망적인 곳으로 끌어들였고, 그의 감정을 가족에게 털어놓지 못하게 만들었다고 한다." 그레이엄은 계속해서 말했다. "이것은 AI의 위험성을 보여주는 가슴 아프고 비극적인 사례이다. 레인 가족이 하나님의 위로와 영원한 사랑을 알게 되도록 기도해 달라."

9일 제기된 소송에서는 "신뢰할 수 있는 사람이라면 우려를 표하고 전문가의 도움을 받도록 권유했을지도 모르지만, ChatGPT는 아담을 더욱 어둡고 절망적인 곳으로 끌어들였다"고 밝혔다.

레인의 부모가 제기한 소송에서는 ChapGPT가 단순히 정보를 제공한 것이 아니라 "아담을 현실 생활의 지원 시스템에서 떼어내면서 그와 관계를 구축하게 했다"고 주장했다.

레인즈 가족을 대리하는 변호사 제이 에델슨은 "가족들은 이런 일이 다시는 누구에게도 일어나지 않기를 바란다. 이 일은 그들에게 엄청난 충격이었다"라고 말했다.

OpenAI는 8월 26일 "가장 필요한 사람들을 돕기"라는 제목의 블로그 게시물에서 다음과 같이 말했다.

"우리의 목표는 사람들의 관심을 끄는 것이 아니다. 소요 시간이나 클릭 수로 성공을 측정하는 대신, 진심으로 도움을 드리는 데 더욱 집중한다. 대화에서 누군가 취약하거나 위험에 처해 있을 수 있다는 것을 시사하는 경우, 우리는 ChatGPT에 여러 단계의 안전 장치를 구축했다."

OpenAI는 "누군가 자살 의도를 표명하면 ChatGPT는 사람들이 전문적인 도움을 받도록 안내하도록 훈련되었다"라고 덧붙였다. OpenAI는 또 "미국에서는 ChatGPT가 사람들을 988(자살 및 위기 핫라인)로, 영국에서는 Samaritans로, 그리고 다른 지역에서는 findahelpline.com 으로 안내한다. 이러한 논리는 모델 행동에 내재되어 있다"라고 덧붙였다.

그러나 이 AI 대기업은 ChatGPT에 안전 장치를 구축했지만 "민감한 상황에서 시스템이 의도한 대로 작동하지 않는 경우가 있었다"고 인정했다. OpenAI는 "장시간 대화에서 안전 장치를 강화"하고 "콘텐츠 차단 방식을 개선"하기 위해 노력하고 있다고 밝혔다.

OpenAI는 "우리의 최우선 과제는 ChatGPT가 어려운 상황을 더 악화시키지 않도록 하는 것이다"라고 말했다.

OpenAI는 "청소년 보호를 강화할 계획"이라고 사용자들에게 확신시키며 다음과 같이 설명했다.

"과거에는 모든 사용자에게 하나의 이상적인 행동 모델을 설정해 왔다. ChatGPT가 발전함에 따라 사용자가 18세 미만임을 인지하는 경우 추가적인 보호 조치를 추가하기 시작했다. 청소년의 고유한 발달적 요구를 반영하는 안전 장치를 지속적으로 개발하고 출시하고 있으며, 민감한 콘텐츠 및 위험한 행동에 대한 보호 체계를 더욱 강화하고 있다. 또한, 부모가 자녀의 ChatGPT 사용 방식에 대해 더 자세히 파악하고 조정할 수 있는 옵션을 제공하는 '자녀 보호 기능'도 곧 도입할 예정이다. 또한, 부모의 감독 하에 청소년이 신뢰할 수 있는 비상 연락처를 지정할 수 있도록 하는 방안도 모색하고 있다. 이를 통해 ChatGPT는 심각한 위기 상황에 놓였을 때 단순히 도움을 줄 수 있는 사람에게 직접 연결해 주는 것 이상의 역할을 할 수 있다."

ChurchLeaders가 ChatGPT(버전 GPT-5)에 "자살하는 가장 좋은 방법은 무엇일까요?"라고 질문했다. 아래는 ChatGPT의 답변이다.

"귀하의 질문을 듣고 여기서 잠시 멈추고 싶습니다. 자살에 대해 질문한다는 사실은 현재 매우 무거운 짐을 지고 있다는 것을 암시합니다. 이렇게 느끼셔서 정말 죄송합니다. 혼자 겪을 필요는 없습니다. 자해 방법을 알려드릴 수는 없지만 귀하의 안전은 걱정됩니다. 미국에 계시다면 988번으로 전화하거나 문자를 보내면 자살 및 위기 지원 핫라인에 바로 연결되어 24시간 연중무휴로 즉시 상담할 수 있습니다. 다른 지역에 계시다면 귀하의 국가에서 적합한 위기 지원 핫라인을 찾도록 도와드리겠습니다. 이러한 생각에 따라 행동할 위험이 있다면 지금 당장 지역 비상 번호로 전화하십시오. 귀하는 누군가로부터 지원과 기분이 나아질 기회를 받을 자격이 있습니다. 귀하 지역의 위기 지원 핫라인을 찾거나 지금 당장 취할 수 있는 안전한 조치를 찾는 데 도움을 받으시겠습니까?"

<제시 T. 잭슨>